halcon中的深度学习_halcon深度学习-程序员宅基地

技术标签: halcon深度学习 halcon中的混淆据说明 深度学习

什么是深度学习?

深度学习是一系列机器学习的方法集合,其算法结构类似于多层级的神经网络。通过对大量的训练样本图像的学习,提取其各个层次的特征,使网络具有判别和推理能力。

深度学习它的主要工作是什么?

如下图,假设黑色圆与白色圆为两种物体,它们在某一 由两种特征建立的二维坐标系上的分布如下。图中的红色曲线就是深度学习算法做的事情(将两种物体尽可能的在特征分布上划分开来),具体的可翻阅文献。

深度学习是不是必要的?

举个例子我们在做分拣工作,一堆螺丝和螺母散落在托盘上需要通过机器进行分拣工作,通过观察我们得到如下特征:螺丝是长条的螺母是圆的,我们完全可以通过这些特征直接写上几行算法完事根本不需要用到深度学习技术。但是当环境特别复杂,一般的算法无法或者很难达到要求时我们就可以使用到深度学习技术。

深度学习的优点与缺点?

缺点:

需要大量的训练样本

训练耗时较长

需要一定的硬件支持

。。。

优点:

黑箱操作,非常简单

能满足复杂环境的需要

只需要标注样本进行训练

。。。

关于halcon中的深度学习:

自halcon17版本开始,halcon就引用了深度学习这一技术应用到图像处理中,为机器视觉行业提升了一个很大的空间和解决方法。

halcon引用这个深度学习技术在halcon中它也是一个黑箱的,只要把模型需要的数据给到即可,使用步骤如下(安装步骤以及环境需要就不提了):

1、准备网络和数据

(1)、读取halcon自带的网络模型

(2)、明确网络需求

(3)、数据预处理

(4)、数据集分割

以halcon17来说,halcon自带有两个网络模型,分别是:

pretrained_dl_classifier_compact.hdl

pretrained_dl_classifier_enhanced.hdl

按照halcon官方文档解释说这两种模型,前者相对于后者要简单很多(网络结构上),后者网络结构比较复杂能适用于较为复杂的训练和判断,然后在消耗上后者代价大于前者。

关于这两个模型对数据的要求可以通过get_dl_classifier_param算子查看:

*读取网络模型

read_dl_classifier ('pretrained_dl_classifier_compact.hdl', DLClassifierHandle)

*读取网络需要的图片大小

get_dl_classifier_param (DLClassifierHandle, 'image_width', DlImageWidth)

get_dl_classifier_param (DLClassifierHandle, 'image_height', DlImageHeight)

*读取网络需要的图片通道数

get_dl_classifier_param (DLClassifierHandle, 'image_num_channels', DlNumChannels)

*读取网络需要的图片灰度值范围

get_dl_classifier_param (DLClassifierHandle, 'image_range_min', DlRangeMin)

get_dl_classifier_param (DLClassifierHandle, 'image_range_max', DlRangeMax)这样一来我们的训练样本图就要做一个预处理,把每个样本图才处理成224*224分辨率、3通道、-127到128亮度级图像。

halcon也提供了一个算子将样本图预处理成满足要求的样本图:preprocess_dl_fruit_example。不过这个算子是有很大局限的,也可以采用下面方法:

for I := 0 to |RawImageFiles| - 1 by 1

*读取样本文件

read_image (Image, RawImageFiles[I])

*将图片缩放到网络model需求的大小

zoom_image_size (Image, Image, DlImageWidth, DlImageHeight, 'constant')

*将图像的灰度缩放成网络model需求范围

convert_image_type (Image, Image, 'real')

RescaleRange:=(DlRangeMax - DlRangeMin)/255.0

scale_image (Image, Image, RescaleRange, DlRangeMin)

*合成三通道图片

count_obj (Image, Number)

for Index := 1 to Number by 1

select_obj (Image, ObjectSelected, Index)

count_channels (ObjectSelected, Channel)

*如果图片不是三通道图,就需要将图像合成三通道图

if (Channel != DlNumChannels)

compose3(ObjectSelected, ObjectSelected, ObjectSelected, ThreeChannelImage)

*替换图元数组

replace_obj (Image, ThreeChannelImage, Image, 1)

endif

endfor

* Write preprocessed image to hobj file.

write_object (Image, ObjectFilesOut[I])

endfor

read_dl_classifier_data_set (PreprocessedFolder, 'last_folder', ImageFiles, Labels, LabelsIndices, Classes)

**拆分数据集**

*训练占比

TrainingPercent := 70

*验证占比

ValidationPercent := 15

*将数据分割成三大块,分别为:训练集(TrainingImages, TrainingLabels)、验证集(ValidationImages, ValidationLabels)、测试集(TestImages, TestLabels)

split_dl_classifier_data_set (ImageFiles, Labels, TrainingPercent, ValidationPercent, TrainingImages, TrainingLabels, ValidationImages, ValidationLabels, TestImages, TestLabels)

stop ()最后可将这些预处理好的文件写出hobj文件保存到外部文件备,也可以通过split_dl_classifier_data_set算子将数据集分割成:训练集、验证集、测试集三份,分别会在后续步骤中使用到。

2、训练网络并评估训练过程

(1)、设置适合训练需要的网络参数

(2)、对数据进行增强和扩充

(3)、开始训练并对训练过程进行评估

超参数是一种人为设置的超参数,它不同于网络模型参数可以在训练中进行评估和优化。也可以理解成为了干预这个“黑盒”过程而暴露出的必要参数,比如说'batch_size'的值决定了学习过程输入的每批次的数据量。。。

关于超参数介绍表:

设置好超参数后可以直接使用到halcon提供的 train_fruit_classifier 算子,这个算子内部包括了训练过程以及将训练好的模型序列化到外部。

**设置超参数**

set_dl_classifier_param (DLClassifierHandle, 'classes', Classes)

BatchSize := 64

set_dl_classifier_param (DLClassifierHandle, 'batch_size', BatchSize)

try

*初始化网络模型

set_dl_classifier_param (DLClassifierHandle, 'runtime_init', 'immediately')

catch (Exception)

dev_disp_error_text (Exception)

stop ()

endtry

*学习率

InitialLearningRate := 0.001

set_dl_classifier_param (DLClassifierHandle, 'learning_rate', InitialLearningRate)

*学习率变化参数

LearningRateStepEveryNthEpoch := 30

LearningRateStepRatio := 0.1

*迭代次数

NumEpochs := 50

**训练分类器**

dev_clear_window ()

* 每次迭代的间隔,它会体现在学习过程中的图标上的‘x’轴

PlotIterationInterval := 100

*将训练好的网络模型序列化

FileName := 'classifier_minist.hdl'

*训练模型

train_fruit_classifier (DLClassifierHandle, FileName, NumEpochs, TrainingImages, TrainingLabels, ValidationImages, ValidationLabels, LearningRateStepEveryNthEpoch, LearningRateStepRatio, PlotIterationInterval, WindowHandle)

dev_disp_text ('Press Run (F5) to continue', 'window', 'bottom', 'right', 'black', [], [])

*清除网络句柄

clear_dl_classifier (DLClassifierHandle)

stop ()如果是调用train_fruit_classifier算子进行系统训练,它会反馈一张图标:

图中两条不断下降的曲线分别是训练过程和验证过程中的错误率曲线,两条线的走势都向0趋近且较为平稳说明这次训练过程中二者的收敛得很好;另一条线先保持水平,到达一定迭代次数后才发生急剧下降的是学习率曲线,表示训练过程已经趋近于稳定了。

为了验证训练结果即评估网络的性能如何,可以观察不同的样本对训练过程的影响。调整learning_rate(学习率)和momentum(动量)两个参数,可以观察迭代过程中错误率和学习率的变化情况。如果知道图像的实际标注信息,可以与网络模型的预测结果做对比,得到正样本与负样本的预测正确率。

或者直接观察反馈图像是否 欠拟合 和 过拟合 。首先,一个网络在学习过程中遇到新的样本时的学习能力称为泛化。好的网络模型泛化性能良好,可以在实际检测中对新样本进行良好的预测。因此在评价网络性能时,泛化能力是一个重要的考量,由此有两个术语:欠拟合和过拟合。

欠拟合,一般是因为训练样本的不足等原因产生的,导致模型在训练集上的误差较大(错误率高)。可以通过增加训练样本或增加特征维度解决。

过拟合,一般是因为模型过度学习了训练样本,导致泛化能力变差,在遇到新的样本上表现较差。过度学习有可能学习过多的特征,甚至把样本的噪声等细节也当成特征。

过拟合的曲线通常表现为以下式样(错误率下降一定程度后急剧上升):

3、应用网络与评估网络

混淆矩阵

*读取序列化网络模型

read_dl_classifier (FileName, DLClassifierHandle)

*计算混淆矩

get_error_for_confusion_matrix (ValidationImages, DLClassifierHandle, Top1ClassValidation)

*生成混淆矩模型

gen_confusion_matrix (ValidationLabels, Top1ClassValidation, [], [], WindowHandle, ConfusionMatrix)

dev_disp_text ('Validation data', 'window', 'top', 'left', 'gray', 'box', 'false')

dev_disp_text ('Press Run (F5) to continue', 'window', 'bottom', 'right', 'black', [], [])

stop ()

*清除混淆矩句柄

clear_matrix (ConfusionMatrix)

dev_clear_window ()

clear_dl_classifier (DLClassifierHandle)下图的结果是我在训练0到9的数字图片样本,其中每个样本文件夹中都有300个样本图片,这3000个图片当中拿出预设的15%(450张)分量的图片样本作为验证集数据得到的混淆矩阵。

混淆矩阵的含义:如果知道图像的实质标注信息,可以与网络模型的预测结果进行对比,得出正样本与负样本的预测正确率。混淆矩阵就是这样一种直观地显示判断结果的工具。

在halcon中,混淆矩阵的每一列代表原图像的真实分类,每一行表示网络预测的结果。混淆矩阵显示了以下分类结果:

1、真正列(TP):属于某类并被预测为某类

2、假正列(FP):不属于某类却被预测为某类

3、真反列(TN):不属于某类,也没被预测为某类

4、假反列(FN):属于某类,却被预测为不属于某类

于是结合反馈的混淆矩阵数据我们可以计算出 精度、召回率、F-Score,它们的公式分别是:

精度=TP/(TP+FP);

召回率=TP/(TP+FN);

F-Score=2(精度*召回率) / (精度+召回率)

从0的分类器上看,TP=44;FP=0;FN=1 => 精度=1;召回率≈0.977

从1的分类器上看,TP=44;FP=0;FN=1 => 精度=1;召回率≈0.977

从2的分类器上看,TP=41;FP=2;FN=4 => 精度≈0.953;召回率≈0.911

。。。

如果一个分类器具有高精度、低召回率,那么该分类器可能识别出了很少的正样本,但是这些正样本的正确率很高;相反,如果该分类器具有低精度、高召回率,那么该分类器能识别出大部分的正样本,但是这些正样本的结果也可能包含了很多误识别的负样本。所以,一个理想的情况是:分类器实现高精度、高召回率。

4、实际检测

注意,当我们把要识别的图片给到之前训练好的模型中去的时候也需要将图片预处理成模型需要的类型和大小,否则报错。

*读取训练好的模型

read_dl_classifier (FileName, DLClassifierHandle)

*限制每次识别图像为1个

set_dl_classifier_param (DLClassifierHandle, 'batch_size', 1)

* 初始化网络环境

set_dl_classifier_param (DLClassifierHandle, 'runtime_init', 'immediately')

*

dev_resize_window_fit_size (0, 0, WindowWidth, WindowHeight, -1, -1)

set_display_font (WindowHandle, 30, 'mono', 'true', 'false')

for Index := 0 to 10 by 1

ImageFile := RawImageFiles[floor(rand(1) * |RawImageFiles|)]

read_image (Image, ImageFile)

*将图片缩放到网络model需求的大小

zoom_image_size (Image, Image, DlImageWidth, DlImageHeight, 'constant')

*将图像的灰度缩放成网络model需求范围

convert_image_type (Image, Image, 'real')

RescaleRange:=(DlRangeMax - DlRangeMin)/255.0

scale_image (Image, Image, RescaleRange, DlRangeMin)

count_channels (Image, Channel)

*如果图片不是三通道图,就需要将图像合成三通道图

if (Channel != DlNumChannels)

compose3(Image, Image, Image, Image)

endif

*使用已经训练号的深度学习网络识别一组图像

apply_dl_classifier (Image, DLClassifierHandle, DLClassifierResultHandle)

*获取识别结果

get_dl_classifier_result (DLClassifierResultHandle, 'all', 'predicted_classes', PredictedClass)

*清除当前识别的句柄

clear_dl_classifier_result (DLClassifierResultHandle)

*

dev_display (Image)

Text := 'Predicted class: ' + PredictedClass

dev_disp_text (Text, 'window', 'top', 'left', 'red', 'box', 'false')

dev_disp_text ('Press Run (F5) to continue', 'window', 'bottom', 'right', 'black', [], [])

stop ()

endfor

clear_dl_classifier (DLClassifierHandle)

效果展示:

。。。。

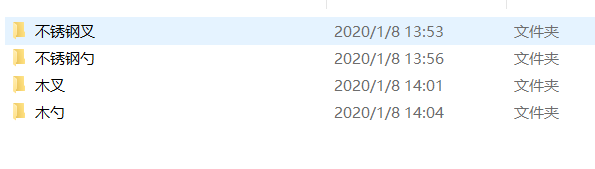

然后从百度图库中下载几张图片进行训练(分了4类,每类10张图片):

效果:

注:部分文献参考于《机器视觉算法原理与编程实践》

智能推荐

class和struct的区别-程序员宅基地

文章浏览阅读101次。4.class可以有⽆参的构造函数,struct不可以,必须是有参的构造函数,⽽且在有参的构造函数必须初始。2.Struct适⽤于作为经常使⽤的⼀些数据组合成的新类型,表示诸如点、矩形等主要⽤来存储数据的轻量。1.Class⽐较适合⼤的和复杂的数据,表现抽象和多级别的对象层次时。2.class允许继承、被继承,struct不允许,只能继承接⼝。3.Struct有性能优势,Class有⾯向对象的扩展优势。3.class可以初始化变量,struct不可以。1.class是引⽤类型,struct是值类型。

android使用json后闪退,应用闪退问题:从json信息的解析开始就会闪退-程序员宅基地

文章浏览阅读586次。想实现的功能是点击顶部按钮之后按关键字进行搜索,已经可以从服务器收到反馈的json信息,但从json信息的解析开始就会闪退,加载listview也不知道行不行public abstract class loadlistview{public ListView plv;public String js;public int listlength;public int listvisit;public..._rton转json为什么会闪退

如何使用wordnet词典,得到英文句子的同义句_get_synonyms wordnet-程序员宅基地

文章浏览阅读219次。如何使用wordnet词典,得到英文句子的同义句_get_synonyms wordnet

系统项目报表导出功能开发_积木报表 多线程-程序员宅基地

文章浏览阅读521次。系统项目报表导出 导出任务队列表 + 定时扫描 + 多线程_积木报表 多线程

ajax 如何从服务器上获取数据?_ajax 获取http数据-程序员宅基地

文章浏览阅读1.1k次,点赞9次,收藏9次。使用AJAX技术的好处之一是它能够提供更好的用户体验,因为它允许在不重新加载整个页面的情况下更新网页的某一部分。另外,AJAX还使得开发人员能够创建更复杂、更动态的Web应用程序,因为它们可以在后台与服务器进行通信,而不需要打断用户的浏览体验。在Web开发中,AJAX(Asynchronous JavaScript and XML)是一种常用的技术,用于在不重新加载整个页面的情况下,从服务器获取数据并更新网页的某一部分。使用AJAX,你可以创建异步请求,从而提供更快的响应和更好的用户体验。_ajax 获取http数据

Linux图形终端与字符终端-程序员宅基地

文章浏览阅读2.8k次。登录退出、修改密码、关机重启_字符终端

随便推点

Python与Arduino绘制超声波雷达扫描_超声波扫描建模 python库-程序员宅基地

文章浏览阅读3.8k次,点赞3次,收藏51次。前段时间看到一位发烧友制作的超声波雷达扫描神器,用到了Arduino和Processing,可惜啊,我不会Processing更看不懂人家的程序,咋办呢?嘿嘿,所以我就换了个思路解决,因为我会一点Python啊,那就动手吧!在做这个案例之前先要搞明白一个问题:怎么将Arduino通过超声波检测到的距离反馈到Python端?这个嘛,我首先想到了串行通信接口。没错!就是串口。只要Arduino将数据发送给COM口,然后Python能从COM口读取到这个数据就可以啦!我先写了一个测试程序试了一下,OK!搞定_超声波扫描建模 python库

凯撒加密方法介绍及实例说明-程序员宅基地

文章浏览阅读4.2k次。端—端加密指信息由发送端自动加密,并且由TCP/IP进行数据包封装,然后作为不可阅读和不可识别的数据穿过互联网,当这些信息到达目的地,将被自动重组、解密,而成为可读的数据。不可逆加密算法的特征是加密过程中不需要使用密钥,输入明文后由系统直接经过加密算法处理成密文,这种加密后的数据是无法被解密的,只有重新输入明文,并再次经过同样不可逆的加密算法处理,得到相同的加密密文并被系统重新识别后,才能真正解密。2.使用时,加密者查找明文字母表中需要加密的消息中的每一个字母所在位置,并且写下密文字母表中对应的字母。_凯撒加密

工控协议--cip--协议解析基本记录_cip协议embedded_service_error-程序员宅基地

文章浏览阅读5.7k次。CIP报文解析常用到的几个字段:普通类型服务类型:[0x00], CIP对象:[0x02 Message Router], ioi segments:[XX]PCCC(带cmd和func)服务类型:[0x00], CIP对象:[0x02 Message Router], cmd:[0x101], fnc:[0x101]..._cip协议embedded_service_error

如何在vs2019及以后版本(如vs2022)上添加 添加ActiveX控件中的MFC类_vs添加mfc库-程序员宅基地

文章浏览阅读2.4k次,点赞9次,收藏13次。有时候我们在MFC项目开发过程中,需要用到一些微软已经提供的功能,如VC++使用EXCEL功能,这时候我们就能直接通过VS2019到如EXCEL.EXE方式,生成对应的OLE头文件,然后直接使用功能,那么,我们上篇文章中介绍了vs2017及以前的版本如何来添加。但由于微软某些方面考虑,这种方式已被放弃。从上图中可以看出,这一功能,在从vs2017版本15.9开始,后续版本已经删除了此功能。那么我们如果仍需要此功能,我们如何在新版本中添加呢。_vs添加mfc库

frame_size (1536) was not respected for a non-last frame_frame_size (1024) was not respected for a non-last-程序员宅基地

文章浏览阅读785次。用ac3编码,执行编码函数时报错入如下:[ac3 @ 0x7fed7800f200] frame_size (1536) was not respected for anon-last frame (avcodec_encode_audio2)用ac3编码时每次送入编码器的音频采样数应该是1536个采样,不然就会报上述错误。这个数字并非刻意固定,而是跟ac3内部的编码算法原理相关。全网找不到,国内音视频之路还有很长的路,音视频人一起加油吧~......_frame_size (1024) was not respected for a non-last frame

Android移动应用开发入门_在安卓移动应用开发中要在活动类文件中声迷你一个复选框变量-程序员宅基地

文章浏览阅读230次,点赞2次,收藏2次。创建Android应用程序一个项目里面可以有很多模块,而每一个模块就对应了一个应用程序。项目结构介绍_在安卓移动应用开发中要在活动类文件中声迷你一个复选框变量