”LayerNorm“ 的搜索结果

LayerNorm层归一化

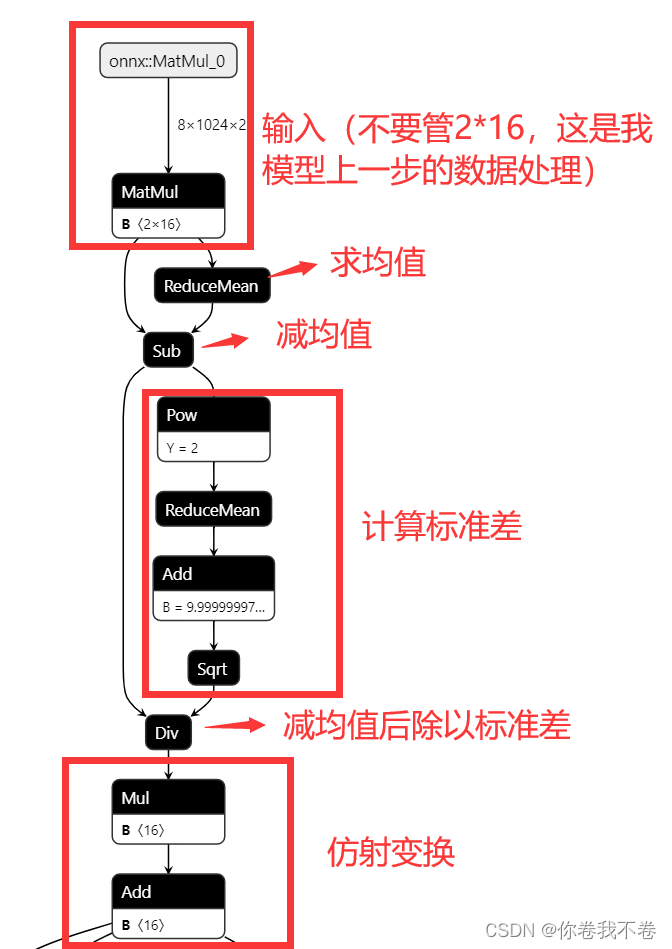

onnx计算图优化 计算图匹配 计算图融合 layerNorm融合 groupNorm融合 计算图匹配: 计算图匹配是图优化的一种技术,它通过搜索和匹配计算图中的特定模式或子图,然后应用预定义的优化规则来替换这些模式。这种方法...

本文是FasterTransformer Decoding 源码分析的第三篇,主要介绍FasterTransformer中LayerNorm是如何实现及优化的。首先会简单介绍下LayerNorm的背景知识,然后从源码上逐层向下分析具体的实现。

weight和bias也分别包含15个数字,分别对15个归一化后的数字进行仿射变换(仿射变换即乘以weight中对应的数字后,然后加bias中对应的数字),并会在反向传播时得到学习。如果输入的是个list或者torch.Size,比如[3, ...

这样的顺序对于训练更深的网络可能更稳定,因为归一化的输入可以帮助缓解训练过程中的梯度消失和梯度爆炸问题。比于LN,可以发现,不论是分母的方差和分子部分,都取消了均值计算,经作者在各种场景中实验发现,减少...

LayerNorm是Transformer的最优解吗?.rar

在深入探索`transformer`模型时,一个不可忽视的组成部分便是`LayerNorm`,它在模型的优化过程中起着关键作用。相比之下,虽然`BatchNorm`也广泛应用于各种网络模型中,但在很多情况下`LayerNorm`表现出更优的效果。...

点击下方卡片,关注“CVer”公众号AI/CV重磅干货,第一时间送达要知道近年来特别出现了很多Transformer面试题(毕竟当前AI顶流)。...介绍Transformer和ViT介绍Transformer的QKV介绍Layer NormalizationTrans...

MXnet LayerNorm pytorch LayerNorm 说明 LayerNorm中不会像BatchNorm那样跟踪统计全局的均值方差,因此train()和eval()对LayerNorm没有影响。 LayerNorm参数 torch.nn.LayerNorm( normalized_shape: ...

Pytorch LayerNorm源码详解

思想与BatchNorm一致,都是通过将某一部分变为均值为0,方差为1来正则化。,并且可以通过学习参数 γ 将其变为方差/均值为任意值的参数。方法:Pytorch。

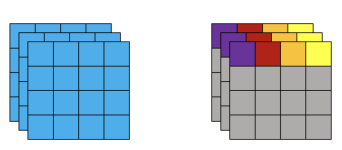

来源:Deephub Imba 本文约2000字,建议阅读5分钟 本文将使用合成数据集对三种归一化技术进行比较,并在每种配置下...归一化技术的选择(Batch, Layer, GroupNormalization)会显著影响训练动态和最终的模型性能。...

layerNorm和batchNorm

BatchNorm、LayerNorm的概念、作用、实现

Pytorch常用的函数(六)常见的归一化总结(BatchNorm/LayerNorm/InsNorm/GroupNorm)

这里手动计算 LN,本篇把我前两天闲的没事干写的验证代码放上了,还是上一篇的问题,有木有大佬解决一下我上一篇的问题,LayerNorm的图是画错了,还是我理解错了。

LayerNorm在rnn和具有动态或小批量大小的任务的背景下可以发挥作用。GroupNorm提供了一个中间选项,在不同的批处理大小上提供一致的性能,在cnn中特别有用。归一化层是现代神经网络设计的基石,通过了解BatchNorm、...

【代码】【LayerNorm 2d】 LayerNorm2d torch代码实现。

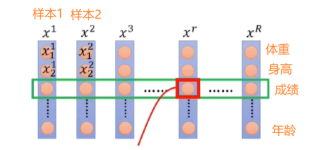

如下图所示,为layer norm的解释图,可以看出layer norm是针对一个token来做的归一化操作。通过输出上的对比我们发现了,使用torch来LN后的EM和我们手动来对Token进行LN的数值一样,说明了LN就是对Token来进行归一会...

推荐文章

- EVO-CNN-LSTM-multihead-Attention能量谷算法优化模型结合多头注意力机制多维时序预测-程序员宅基地

- Objective-C 中的id到底是什么-程序员宅基地

- 好记性不如烂笔头---Archlinux优化简介-程序员宅基地

- 3DREM16P-7X/250YG24-8K4V比例减压阀放大器-程序员宅基地

- python文件操作(open()、write()、writelines()、read()、readline()、readlines()、seek()、os)_python open writeline-程序员宅基地

- 分布式限流实战--redis实现令牌桶限流_分布式令牌限流-程序员宅基地

- 【Linux】文件系统-程序员宅基地

- python实现ks算法_python, 在信用评级中,计算KS statistic值-程序员宅基地

- 类加载过程 与 代码的执行顺序_类加载后代码的执行顺序-程序员宅基地

- Oracle LiveLabs实验:Introduction to Oracle Spatial Studio_oracle_spatial 可视化-程序员宅基地