”bert“ 的搜索结果

BERT

标签: JupyterNotebook

BERT

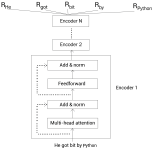

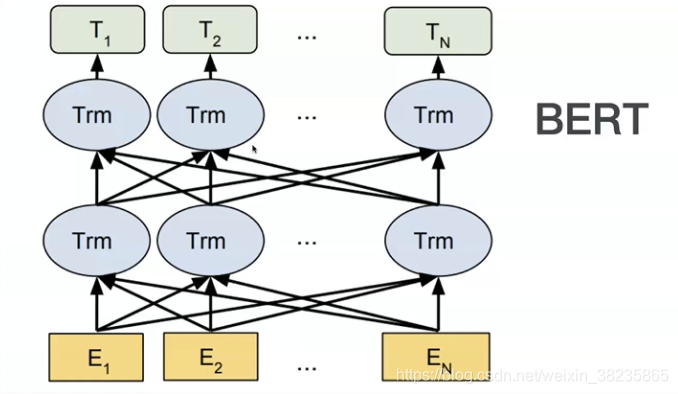

BERT(Bidirectional Encoder Representations from Transformers)是一种预训练模型,它是自然语言处理(NLP)领域的重大里程碑,被认为是当前的State-of-the-Art模型之一。BERT的设计理念和结构基于Transformer...

本课件是对论文 BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding 的导读与NLP领域经典预训练模型 Bert 的详解,通过介绍NLP领域对通用语言模型的需求,引入 Bert 模型,并对其...

深入浅出 BERT

随着一些奇怪的高维数据出现,比如图像、语音,传统的统计学-机器学习方法遇到了前所未有的挑战。数据维度过高,数据单调,噪声分布广,传统的特征工程很难奏效。为了解决高维度的问题,出现的线性学习的PCA降维方法...

BERT 在CV领域,可以通过训练一个大的CNN模型作为预训练模型,来帮助其他任务提高各自模型的性能,但是在NLP领域,没有这样的模型,而BERT的提出,解决了这个问题 BERT和GPT、ELMO的区别: BERT是用来预训练深双向...

BERT详解:概念、原理与应用

在pytorch上实现了bert模型,并且实现了预训练参数加载功能,可以加载huggingface上的预训练模型参数。 主要包含以下内容: 1) 实现BertEmbeddings、Transformer、BerPooler等Bert模型所需子模块代码。 2) 在子模块...

1、内容概要:本资源主要基于bert(keras)实现文本分类,适用于初学者学习文本分类使用。 2、数据集为电商真实商品评论数据,主要包括训练集data_train,测试集data_test ,经过预处理的训练集clean_data_train和...

今天对 bert 大厂常见面试题进行汇总,a. Self-Attention的表达式b. 为什么上面那个公式要对QK进行scalingc. self-attention一定要这样表达吗?d. 有其他方法不用除根号dk吗?e. 为什么transformer用LayerNorm。

a1a_1a1和a2a_2a2这些权值也是根据具体的任务学习出来的。

Fast-Bert是一个深度学习库,允许开发人员和数据科学家针对基于文本分类的自然语言处理任务训练和部署基于BERT和XLNet的模型。 FastBert的工作建立在优秀的提供的坚实基础上,并受到启发,并致力于为广大的机器...

在Pyrotch上实现情感分类模型,包含一个BERT 模型和一个分类器(MLP),两者间有一个dropout层。BERT模型实现了预训练参数加载功能,预训练的参数使用HuggingFace的bert_base_uncased模型。同时在代码中实现了基于预...

书籍

BERT-pytorch

标签: Python

伯特·比托奇 Google AI的2018 BERT的Pytorch实现,带有简单注释BERT 2018 BERT:用于语言理解的深度双向变压器的预培训论文URL: : 介绍Google AI的BERT论文显示了在各种NLP任务(新的17个NLP任务SOTA)上的惊人...

BERT的对抗性嵌入 上基于BERT的情感分类对抗嵌入生成与分析。 建立在对Google Research之上。 IMDB加载器和处理器功能取自。 存储库还包括一种算法,用于投影对抗性嵌入内容以获得对抗性离散文本候选对象。 尽管该...

BERT模型中的注意力机制详解

标签: 开发技术

[BERT模型中的注意力机制详解](https://img-blog.csdnimg.cn/direct/3e71d6aa0183439690460752bf54b350.png) # 2.1 注意力机制的定义和分类 ### 2.1.1 软性注意力和硬性注意力 **软性注意力**:将输入序列中的每个...

python 3.7tqdmsklearn我们豆瓣评论数据集为DMSC.csv格式,而原项目的数据集是从中抽取了20万条新闻标题,文本长度在20到30之间。一共10个类别,每类2万条。数据以字为单位输入模型。THUCNews├── data│ ├── ...

使用说明保存预训练模型在数据文件夹下├──数据│├──bert_config.json │├──config.json │├──pytorch_model.bin │└──vocab.txt ├──bert_corrector.py ├──config.py ├──logger.py ├──...

https://huggingface.co/google-bert/bert-base-uncased pytorch和tensorflow都有

Bert

https://huggingface.co/google-bert/bert-base-chinese pytorch和tensorflow都有

推荐文章

- Python Django 版本对应表以及Mysql对应版本_django版本和mysql对应关系-程序员宅基地

- Maven的pom.xml文件结构之基本配置packaging和多模块聚合结构_pom <packaging>-程序员宅基地

- Composer 原理(二) -- 小丑_composer repositories-程序员宅基地

- W5500+F4官网TCPClient代码出现IP读取有问题,乱码问题_w5500 ping 网络助手 乱码 send(sock_tcps,tcp_server_buff,-程序员宅基地

- Python 攻克移动开发失败!_beeware-程序员宅基地

- Swift4.0_Timer 的基本使用_swift timer 暂停-程序员宅基地

- 元素三大等待-程序员宅基地

- Java软件工程师职位分析_java岗位分析-程序员宅基地

- Java:Unreachable code的解决方法_java unreachable code-程序员宅基地

- 标签data-*自定义属性值和根据data属性值查找对应标签_如何根据data-*属性获取对应的标签对象-程序员宅基地