本文转自:http://blog.csdn.net/zcf1002797280/article/details/49560961在Hadoop/bin 目录下使用下列命令,前面要加./ls 命令hadoop fs -ls /列出hdfs文件系统根目录下的目录和文件hadoop fs -ls -R /列出hdfs文件...

”hdfs“ 的搜索结果

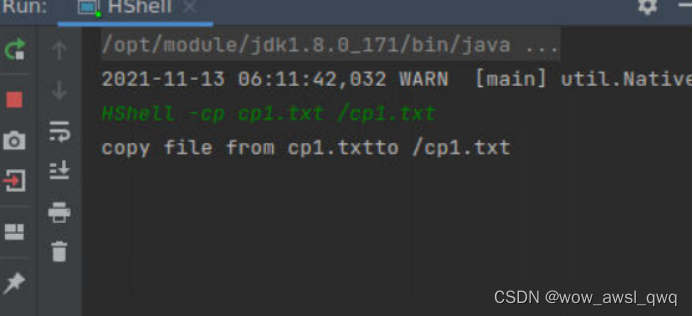

目录: 前提 在VMware中查找虚拟机的IP地址 启动putty 启动Hadoop ...2、向HDFS中上传任意文本文件,如果指定的文件在HDFS中已经存在,由用户指定是追加到原有文件末尾还是覆盖原有的文件(第二种...

python使用pyarrow读写hdfs,将hdfs上的文件读出来,转成pandas的dataframe(就可以使用pandas做进一步分析处理),然后以parquet格式再写回hdfs

从HDFS到Hive的数据导入(静态分区、动态分区)

大数据,hadoop,hdfs配置,java开发

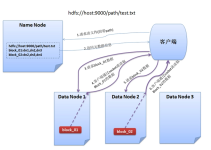

三、向HDFS写数据的过程 客户端先向NameNode发出创建文件的请求 NameNode告诉它应该将文件放在哪个DataNode上 客户端连接那个DataNode,再向它发送要写的数据 DataNode收到数据后保存数据,同时将数据副本放到其他...

一、NameNode 主节点,经常简写为NN,用于管理整个文件目录树 管理各DataNode主机,协调它们之间的配合,监视DataNode的生存情况,对长时间无反应的...HDFS支持DataNode热扩展,即随时加入新的DataNode而不需要重启Nam

HDFS的概念-HDFS联盟.pdf 学习资料 复习资料 教学资源

HDFS是Hadoop中自带的分布式文件系统,具有高容错、运行在廉价的机器上和高吞吐等特性。1、hdfs命令格式lHadoop fs:使用面最广,可以操作任何文件系统。lhadoop dfs与hdfs dfs:只能操作HDFS文件系统相关(包括与...

HDFS的audit log产生数据量很大,速度也很快,在机器系统盘上必须立即持久化到HDFS,否则数据会被覆盖或者磁盘会打满。 用于数据治理-HDFS废弃文件、Hive废弃表检测与清理。 2、实现 ① Apache Flume官网下载最新...

HDFS Snapshot快照,HDFS快照介绍和作用,HDFS快照的实现,HDFS快照的命令,HDFS快照功能启停命令,HDFS快照操作相关命令,案例实操快照的使用

Hadoop HDFS的特点与优缺点

HDFS支持两种RESTful接口:WebHDFS和HttpFS。 WebHDFS默认端口号为50070,HttpFS默认端口号为14000。 默认启动WebHDFS而不会启动HttpFS,而HttpFS需要通过sbin/httpfs.sh来启动。 WebHDFS模式客户端和DataNode直接...

首先启动hdfs,启动方式可见上一个博文,或者单独启动hdfs,方式就是运行 start-dfs.sh启动成功后,输入jps可以看到至少一个namenode和至少一个datanode 和一个jps一、创建路径 mkdir如果你的 HDFS home 目录不存在...

1.查看hdfs下根目录下的文件 hdfs dfs -ls / 2.查看hdfs某个目录下的所有文件结构: 如:查看根目录所有文件结构 hdfs dfs -ls -R / hdfs dfs -lsr / 如:查看根文件tmp下的所有文件列表 hdfs dfs -ls -R /tmp/ ...

推荐文章

- 实验一:C++简单程序设计-程序员宅基地

- 5种好用的Python工具分享_pythontutor-程序员宅基地

- EasyUi 权限-程序员宅基地

- nodejs安装失败_nodejs setup wizard ended-程序员宅基地

- jar包下载到本地maven库,_scala-parser-combinators_2.11-1.0.4.jar坐标-程序员宅基地

- DBGridEh大全_dbgrideh 分页-程序员宅基地

- 过采样与欠采样&图像重采样(上采样&下采样)_欠采样和过采样原理-程序员宅基地

- 苹果计算机的优势,苹果笔记本的优缺点详细分析-程序员宅基地

- FCKeditor 2.6.4.1配置--我是新手-程序员宅基地

- xml文件基本格式与解析(一)_xml格式-程序员宅基地