文章目录前期准备检查MySQL检查Hadoop开始安装1、在MySQL中创建hive元数据库2、上传安装包并解压2.1解压3、配置环境变量3.1检查环境变量是否配置完毕4、修改配置文件4.1进入hive-1.2.1/conf目录,复制备份文件并重...

”hive“ 的搜索结果

Hive引擎简介 Hive引擎包括:默认MR、tez、spark Hive on Spark:Hive既作为存储元数据又负责SQL的解析优化,语法是HQL语法,执行引擎变成了Spark,Spark负责采用RDD执行。 Spark on Hive : Hive只作为存储元数据...

中位数(Median)又称中值,统计学中的专有名词,是按顺序排列的一组数据中居于中间位置的数,代表一个样本、种群或概率分布中的一个数值,其可将数值集合划分为相等的上下两部分。对于有限的数集,可以通过把所有...

如何提高Hive 的查询性能? Apache Hive是一种强大的数据分析工具。在处理数PB的数据时,了解如何提高查询性能非常重要。以下内容是基于 HDP-2.6.4 版本汇总的,如有不足之处,望指出。 1、使用Tez引擎 Apache ...

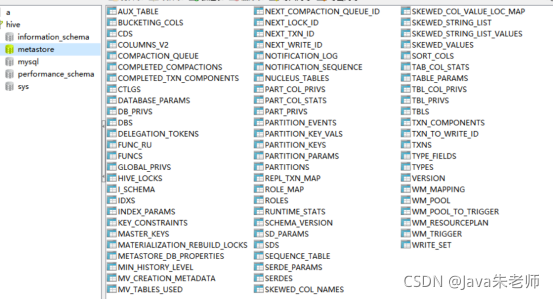

一、hive的安装 hive3.1.2的连接地址 http://archive.apache.org/dist/hive/hive-3.1.2/ 1、下载后上传到/opt/apps下 2、解压 tar -zxvf apache-hive-3.1.2-bin.tar.gz 3、重命名 mv apache-hive-3.1.2-bin hive-...

如何删除hive表中的一个字段?

Hive建表语句

hdfs dfs -cp 回收站目录数据/* 数据表存储目录/对恢复后的数据表进行验证,包括数据内容和数据条数的验证。(2)将回收站里的数据复制到表的数据存储目录。(3)执行hive的修复命令。

Hive SQL 语句常用关键词解释。

Hive最全常见错误及解决方案

标签: hive

(1)导错驱动包,应该把mysql-connector-java-5.1.27-bin.jar导入/opt/module/hive/lib的不是这个包。错把mysql-connector-java-5.1.27.tar.gz导入hive/lib包下。 (2)修改user表中的主机名称没有都修改为%,而是...

1.Hive如何显示当前数据库 2.根据需求设置是否需要执行MR 3.如何正确启动Hive

说下为什么要使用Hive?Hive的优缺点?Hive的作用是什么?

spark on hive : hive只作为存储角色,spark 负责sql解析优化,底层运行的还是sparkRDD 具体可以理解为spark通过sparkSQL使用hive语句操作hive表,底层运行的还是sparkRDD, 步骤如下: 1.通过sparkSQL,加载...

操作都会输出执行过程信息,如执行查询...Hive Shell 非交互式运行。的交互式模式和非交互式模式下,执行。Hive Shell 常用命令。本关任务:按照编程要求,在。选项可以禁止输出此类信息。开始你的任务吧,祝你成功!

Hive详解之参数和变量设置

标签: hive

hive 参数、变量 hive当中的参数、变量,都是以命名空间开头 通过${}方式进行引用,其中system、env下的变量必须以前缀开头 注:临时会话参数 hive -d val=1; 或者 hive -define val=1; 或者 hive --hivevar val...

hive.session.id 会话的ID,一般为用户名和用户名 mapreduce.job.queuename 指定提交到的hadoop队列 mapred.job.priority 设置队列优先级 hive.mapred.mode 设置mapreduce模式,如果...

Hive表权限 hive 一、赋角色权限 –创建和删除角色 create role role_name; drop role role_name; –展示所有roles show roles –赋予角色权限 grant select on database db_name to role role_name; grant select ...

hive> select current_database(); OK test2 建表 hive> create table test_user( > id int, > name string > ) > row format delimited > fields terminated by ',' #以逗号作为列的...

Doris和Hive是两种开源的数据仓库工具,都可以用来分析大型数据集。 Doris是由阿里巴巴开发的一款大数据分析工具,具有低延迟、高吞吐、高可扩展性等优点。它采用PAL(Parallel & Analytic)引擎来实现大规模并行...

建了个宽表,用到collect_list...java.lang.RuntimeException: org.apache.hadoop.hive.ql.metadata.HiveException: Hive Runtime Error while processing row at org.apache.hadoop.hive.ql.exec.mr.ExecMapper.map..

Hive连接器允许查询存储在Hive数据仓库中的数据。Hive是三个组件的组合: 各种格式的数据文件通常存储在Hadoop分布式文件系统(HDFS)或Amazon S3中。 有关如何将数据文件映射到架构和表的元数据。此元数据存储在...

推荐文章

- 反编译delphi_反编译Delphi(1/3)-程序员宅基地

- node_acl用法示例_node acl-程序员宅基地

- 使用STM32提供的DSP库进行FFT_stm32的dsp库 直流分量-程序员宅基地

- VScode 报错 :crbug/1173575, non-JS module files deprecated._crbug/1173575是什么原因-程序员宅基地

- C++学习_3-程序员宅基地

- eigen 构造变换矩阵(Eigen::Isometry3d或者Eigen::Matrix4d)的几种方式-程序员宅基地

- C++ 如何初始化静态类成员(静态成员必须在.cpp文件中初始化)_c++ 静态成员变量初始化-程序员宅基地

- 48,原子核物理实验方法篇_短时间的高剂量照射后果-程序员宅基地

- el-dialog修改默认内边距_el-dialog__body修改padding-程序员宅基地

- 公网下远程树莓派Raspberry Pi的SSH/WOL/监控/桌面的实现_ssh wol-程序员宅基地