”rmsprop“ 的搜索结果

这个加权平均称为“动量”,它可以帮助RMSprop在。利用加权平均值调整了权重值和偏差值的震荡幅度,进而提高了训练的稳定性和速度。迭代进行Mini-batch,针对每次迭代t:。来控制动量的更新速度。

RMSProp是一种基于自适应学习率的优化算法,它通过适应性地更新学习率,有效地解决了普通随机梯度下降(SGD)算法中学习率过大或过小的问题。作为一种基于自适应学习率的优化算法,RMSProp通过考虑参数梯度的历史...

在上一篇文章里,我们介绍了AdaGrad,引入了二阶动量来调整不同参数的学习速率,同时它的缺点就是不断地累加二阶动量导致最终学习率会接近于0导致训练提前终止,RMSProp主要针对这个问题进行了优化。AdaGrad的二阶...

RMSProp(Root Mean Square Propagation)是一种自适应学习率的优化算法,主要用于深度学习中的参数更新。旨在解决 Adagrad 算法在深度学习训练过程中学习率逐渐减小直至无法进一步学习的问题。

Hi,兄弟们,这里是肆十二,今天我们来讨论一下深度学习中的RMSprop优化算法。RMSprop算法是一种用于深度学习模型优化的自适应学习率算法。它通过调整每个参数的学习率来优化模型的训练过程。下面是一个RMSprop算法...

RMSProp算法1

标签: 算法

算法介绍不同于AdaGrad算法中状态变量是截至时间步t所有小批量随机梯度按原始平方和,RMSProp苏纳法将这些梯度按元素平方做指数加权移动平均,即:给定超参

实现传统的LMS算法,并使用AdaGrad、RMSProp、Adam这三种自适应学习率优化算法对LMS算法进行优化。

RMSprop 翻译成中文是“均方根传递”,它也能加速算法学习的速度。 仍然使用上篇文章中的图: 在此,我们假设 W 为水平方向的参数,b 为竖直方向的参数。从上图可以看出,更新 W 时的步伐过小,而更新 b 的步伐过...

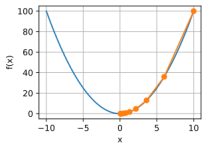

RMSprop算法全称是root mean square prop算法,该算法可以加速梯度下降,回忆一下之前的例子,如果执行梯度下降,虽然横轴方向正在推进,但纵轴方向会有大幅度的摆动,假设纵轴代表参数b,横轴代表参数W,可能有W1W_...

airfoil4755 下载 ...提取码:dwjq 11.6 Momentum 在 Section 11.4 中,我们提到,目标函数有关自变量的梯度代表了目标函数在自变量当前位置下降最快的方向。因此,梯度下降也叫作最陡下降(steepest descent)。...

MATLAB实现 实现传统的LMS算法,并使用AdaGrad、RMSProp、Adam这三种自适应学习率优化算法对LMS算法进行优化 MATLAB实现 实现传统的LMS算法,并使用AdaGrad、RMSProp、Adam这三种自适应学习率优化算法对LMS算法进行...

基于RMSProp和Momentum优化算法构造BP神经网络实现对Iris数据集的分类源码.zip基于RMSProp和Momentum优化算法构造BP神经网络实现对Iris数据集的分类源码.zip基于RMSProp和Momentum优化算法构造BP神经网络实现对Iris...

分别利用RMSProp和Momentum优化算法构造BP神经网络,实现对Iris数据集的分类(源码及数据集) 分别利用RMSProp和Momentum优化算法构造BP神经网络,实现对Iris数据集的分类(源码及数据集) 分别利用RMSProp和...

这篇文章是优化器系列的第二篇,也是最重要的一篇,上一篇文章介绍了几种基础的优化器,这篇文章讲介绍一些用的最多的优化器:Adadelta、RMSprop、Adam、Adamax、AdamW、NAdam、SparseAdam。这些优化器中Adadelta和...

这篇文章是优化器系列的第二篇,也是最重要的一篇,上一篇文章介绍了几种基础的优化器,这篇文章讲介绍一些用的最多的优化器:Adadelta、RMSprop、Adam、Adamax、AdamW、NAdam、SparseAdam。这些优化器中Adadelta和...

最常用的优化器SGD、mSGD、AdaGrad、RMSProp、Adam、AdamW的介绍和公式,其中AdamW算法是Adam算法的改进,SGD在CNN中还有不错的发挥,但在Transformer中却效果一般,如今Adam和AdamW算法在Transformer模型中有着更为...

1、基于RMSProp和Momentum优化算法构造BP神经网络,实现对Iris数据集的分类研究源码.zip 2、该资源包括项目的全部源码,下载可以直接使用! 3、本项目适合作为计算机、数学、电子信息等专业的课程设计、期末大作业和...

RMSProp算法修改AdaGrad以在非凸设定下效果更好,改变梯度积累为指数加权的移动平均。AdaGrad旨在应用于凸问题时快速收敛。当应用于非凸函数训练神经网络时,学习轨迹可能穿过了很多不同的结构,最终到达一个局部凸...

利用Matlab构建深度前馈神经网络以及各类优化算法的应用(SGD、mSGD、AdaGrad、RMSProp、Adam)-附件资源

MATLAB实现传统的LMS算法,并使用AdaGrad、RMSProp、Adam这三种自适应学习率优化算法对LMS算法进行优化.zip数学建模大赛赛题、解决方案资料,供备赛者学习参考!数学建模大赛赛题、解决方案资料,供备赛者学习参考!...

SGD是最基本的优化算法之一。它通过在每次迭代中计算损失函数关于权重的梯度(对一小批量训练样本),然后沿着梯度的反方向来最小化损失。

推荐文章

- Android RIL框架分析-程序员宅基地

- Python编程基础:第六节 math包的基础使用Math Functions_ps math function-程序员宅基地

- canal异常 Could not find first log file name in binary log index file_canal could not find first log file name in binary-程序员宅基地

- 【练习】生成10个1到20之间的不重复的随机数并降序输出-程序员宅基地

- linux系统扩展名大全,Linux系统文件扩展名学习-程序员宅基地

- WPF TabControl 滚动选项卡_wpf 使用tabcontrol如何给切换的页面增加滚动条-程序员宅基地

- Apache Jmeter常用插件下载及安装及软硬件性能指标_jmeter插件下载-程序员宅基地

- SpringBoot 2.X整合Mybatis_springboot2.1.5整合mybatis不需要配置mapper-locations-程序员宅基地

- ios刷android8.0,颤抖吧 iOS, Android 8.0正式发布!-程序员宅基地

- 【halcon】C# halcon 内存暴增_halcon 读二维码占内存-程序员宅基地