”spark“ 的搜索结果

Spark on Yarn详解

标签: spark

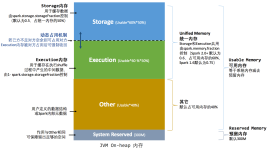

Spark on Yarn详解 Spark 可以跑在很多集群上,比如跑在local上,跑在Standalone上,跑在Apache Mesos上,跑在Hadoop YARN上等等。不管你Spark跑在什么上面,它的代码都是一样的,区别只是–master的时候不一样。...

spark read mysql

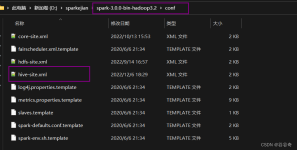

mv spark-2.1.2-bin-hadoop2.7 ./spark 解压到目标目录即完成安装, spark 解压后主要包含如下子目录: bin/ (工具程序目录) conf/ (配置文件目录) jars/ (scala Jar 包目录) python/ (python package 目录) ...

Spark on Hive & Hive on Spark你分清了吗

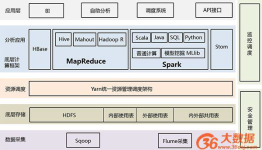

Hive on Spark:Hive既作为存储元数据又负责SQL的解析优化,语法是HQL语法,执行引擎变成了Spark,Spark负责采用RDD执行。 Spark on Hive : Hive只作为存储元数据,Spark负责SQL解析优化,语法是SparkSQL语法,...

Spark-Shell操作 spark-shell简述 spark-shell是REPL(Read-Eval-Print Loop,交互式解释器),它为我们提供了交互式执行环境,表达式计算完成以后就会立即输出结果,而不必等到整个程序运行完毕,因此可以及时...

spark读取clickhouse数据 一:这种jdbc的连接加载的是全量表数据 val prop = new java.util.Properties prop.setProperty("user", "default") prop.setProperty("password", "123456") prop.setProperty("driver...

hue执行不用引擎sql导致任务中断

Hadoop和Spark都是并行计算,Hadoop一个作业称为一个Job,Job里面分为Map Task和Reduce Task阶段,每个Task都在自己的进程中运行,当Task结束时,进程也会随之结束; 好处在于进程之间是互相独立的,每个task独享...

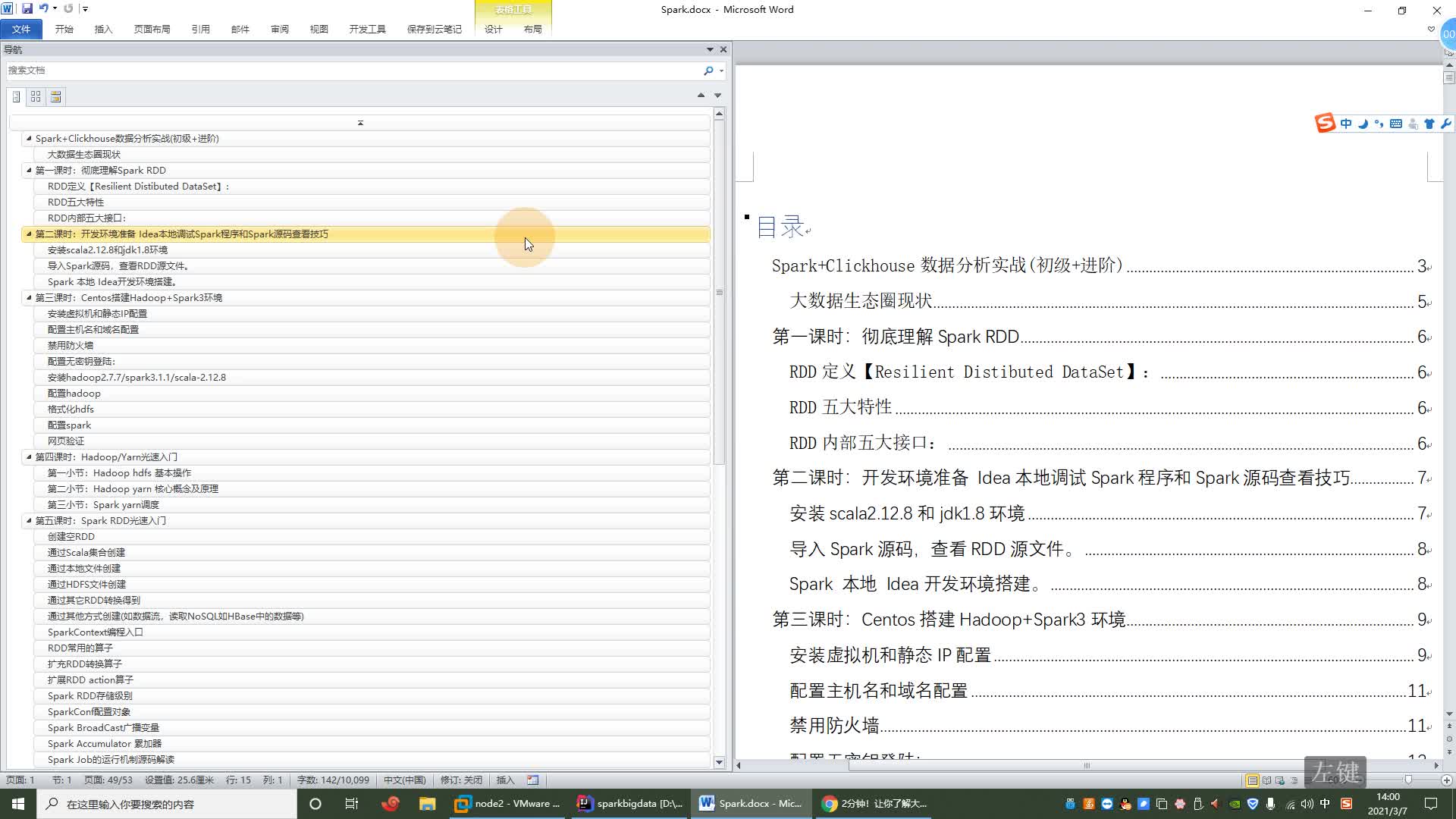

RDD(弹性分布式数据集合)是Spark的基本数据结构,Spark中的所有数据都是通过RDD的形式进行组织。本文讲解RDD的属性、创建方式、广播与累加器等重要知识点,并图解RDD高频算子。

Spark是一种基于内存的快速的、通用、可拓展的大数据分析计算引擎。 一、Spark与MapReduce Hadoop框架中的MapReduce计算引擎,也是一种大数据分析计算引擎。那既然已经又来MR那我们为何还要开发Spark计算模型呢?...

花了将近一个月时间学习了Spark,为了总结所学知识,我用ProcessOn绘制了几张Spark思维导图 这里是Spark思维导图地址 Spark思维导图地址 注意:需要有ProcessOn账号才能查看 1.Spark 入门 2.Spark Core 3.Spark ...

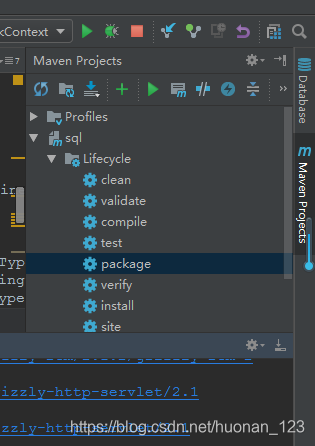

Spark_Submit脚本参数 Spark-submit脚本提交任务时最简易的命令格式如下: ./bin/spark-submit \ --master spark://localhost:7077 \ 任务包 任务参数 而实际开发中用的一般是如下的格式 ./bin/spark-submit \ --...

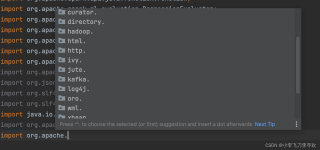

pychrm连接spark

如何处理Spark数据倾斜

标签: 数据倾斜

一、什么是数据倾斜 在分布式集群计算中,数据计算时候数据在各个节点分布不均衡,某一个或几个节点集中80%数据,而其它节点集中20%甚至更少数据,出现了数据计算负载不均衡的现象。 数据倾斜在MR编程模型中是十分...

文章总结:Spark Streaming是Spark的实时流计算API,将连续的流数据按时间间隔划分为数据块,每个块是一个RDD,具备RDD的优点,如快速处理和数据容错性。然而,实时延迟较高,不支持小批处理时间间隔。Spark ...

推荐文章

- 报错Caused by: java.net.ConnectException: Timeout connecting to [localhost/127.0.0.1:9200]-程序员宅基地

- caffe代码阅读4:LayerRegistry的介绍与实现_caffe layerregistry-程序员宅基地

- em启动不了,无法登入数据库。_emd.properties-程序员宅基地

- Vue和SpringBoot实现的流浪宠物领养平台,高质量毕业论文范例可直接参考引用,附送源码、数据库脚本,项目导入与运行教程,论文撰写教程_使用vue2实现流浪猫狗求助平台-程序员宅基地

- 请实现一个函数,把字符串 s 中的每个空格替换成“%20“。_请实现一个函数,把字符串 s 中的每个空格替换成"%20"。-程序员宅基地

- Protocol Buffer——protobuf安装 编译 使用 C++ windows平台 VS19 结合 CMake_protobuf使用windows-程序员宅基地

- java对接海康威视摄像头_java对接海康摄像头-程序员宅基地

- 神经网络与深度学习课程总结(2)-程序员宅基地

- Redis源码学习(20),学习感悟_redis源码有必要看吗-程序员宅基地

- 基于BERT fine-tuning的情感分类_waimai_10k bert-程序员宅基地