”交叉熵“ 的搜索结果

交叉熵(Cross Entropy)是用来衡量两个概率分布之间的差异性的一种方法。在机器学习和深度学习中,交叉熵常常被用作损失函数,用来衡量模型预测的结果与真实结果之间的差距。Hpq−i1∑npilogqi其中,pi表示...

问题:1、交叉熵CH(p,q)公式的p和q分别是随机变量X的两种分布吗?能这样描述吗:p和q是随机变量X的两个样本集。p和q的正确描述应该是怎样的?CH(p,q)就是Venn图里的I(X;Y)吗?交叉熵的值越大或越小说明了什么问题? ...

Softmax、交叉熵、交叉熵损失是机器学习与神经网络模型的重要组成部分,一般来说,Softmax一般用于criterion(标准),交叉熵与交叉熵损失用来衡量模型预测与实际结果间的差别并产生用于反向传播的梯度。...

在二分类问题中, 标签 y 是 1 的似然是对于标签 y 的预测 y^, 同样的, 标签是 0 的似然是 1y^. 我们需要最大化似然函数, 而且, 由于二分类问题的...假设有一个完美的算法, 直接预测出了 1,1,0, 那么交叉熵的结果就是 0.

交叉熵损失函数,PyTorch中标准交叉熵误差损失函数的实现(one-hot形式和标签形式)

交叉熵(Cross-Entropy) 交叉熵是一个在ML领域经常会被提到的名词。在这篇文章里将对这个概念进行详细的分析。 1.什么是信息量? 假设XX是一个离散型随机变量,其取值集合为X\mathcal{X},概率分布函数为p(x)=Pr...

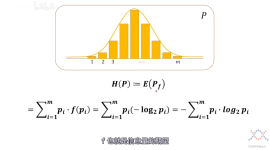

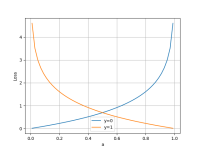

交叉熵是信息论中的一个概念 下面将介绍信息量、熵、相对熵(KL散度)、交叉熵这四个概念。 1. 信息量 假设是一个离散型随机变量,其取值集合为,其概率分布函数, 则定义事件的信息量为: 图像如下: 横轴:...

信息熵: 表示随机变量不确定的度量,是对所有可能发生的事件产生的信息...交叉熵(cross entropy): 将KL散度公式进行变形得到: 前半部分就是p(x)的熵,后半部分就是交叉熵: 机器学习中,我们常常使用KL散度来评估pr

写在前面分类问题和回归问题是监督学习的两大种类。神经网络模型的效果及优化的目标是通

主要介绍了解决pytorch 交叉熵损失输出为负数的问题,具有很好的参考价值,希望对大家有所帮助。一起跟随小编过来看看吧

针对复杂图像的分割问题,提出一种基于生物地理学优化(biogeography-based optimization,BBO)算法的二维交叉熵多阈值图像分割方法。根据二维直方图斜分法得出交叉熵阈值选取公式,并将此推广到多阈值分割,以求得...

我们会发现,在机器学习实战中,做分类问题的时候经常会使用一种损失函数(Loss Function)——交叉熵损失函数(CrossEntropy Loss)。但是,为什么在做分类问题时要用交叉熵损失函数而不用我们经常使用的平方损失...

交叉熵损失函数python实现源码focal_loss.py实际工程项目所用,可供学习参考!

标准的权重也可以通过AHP和交叉熵方法计算。 任何使用密码的人都请引用论文 “ Hussain,SAI,Sen,B.,Das Gupta,A.和Mandal,UK(2020)。新颖的多目标决策和折衷方法,用于选择inconel-800超级合金的最佳加工...

注意,交叉熵刻画的是两个概率分布之间的距离,或可以说它刻画的是通过概率分布q来表达概率分布p的困难程度,p代表正确答案,q代表的是预测值,交叉熵越小,两个概率的分布约接近。 那么,在神经网络中怎样把前...

为了进一步提升建筑物遥感图像分割的准确性和运算速度,本文提出了基于混沌布谷鸟优化的二维 Tsallis交叉熵的建筑物遥感图像分割方法。首先给出了二维 Tsallis交叉熵的阈值选取公式,然后将 Logistic混沌映射引入布...

% MinCEP 是使用最小交叉熵进行阈值化的函数% 图像非空白空间的阈值选择。 % % [ILow, IHigh, 阈值] = minCEP(I) % 输入:I 2D 灰度图像% minIntensity 最小强度% maxIntensity 最大强度% %输出:ILow图像,具有...

最小交叉熵阈值法(MCET) 在二级阈值中是有效的, 但在多极阈值的穷尽搜索中却要付出昂贵的时间代价. 鉴于此, 提出一种基于遗传算法(GA) 的MCET选择方法: 在执行图像分割(IS) 任务之前, 先将IS 转化为在一定约束...

关于交叉熵在loss函数中使用的理解 交叉熵(cross entropy)是深度学习中常用的一个概念,一般用来求目标与预测值之间的差距。以前做一些分类问题的时候,没有过多的注意,直接调用现成的库,用起来也比较方便。...

利用对象交叉熵测度工具,提出最小-最大交叉熵隶属度学习准则,并作为成对约束信息测度项引入到成对约束核聚类的目标函数中,通过拉格朗日最优化处理目标函数,推导出相应聚类算法。实验进一步表明,该算法能够更...

机器学习——交叉熵python实现

标签: 12

机器学习——交叉熵python实现,基于TensorFlow,一般在机器学习做loss评估。

在阈值方法中,最小交叉熵阈值(MCET)由于其简单性和阈值的测量精度而被广泛采用。 尽管在二级阈值化的情况下MCET是有效的,但是当涉及针对多个阈值的详尽搜索的多级阈值化时,它会遇到昂贵的计算。 提出了一种...

最小交叉熵的方法选择“最佳阈值”,它在阈值化过程中会丢失较少的信息。 原理是计算两个分布P和Q之间的距离D。 D(P,Q)=sum pi log(pi/qi)

基于二维Renyi交叉熵的图像分割

论文中"Holistically-Nested Edge Detection"使用的加权损失函数,具体用法见博客http://blog.csdn.net/majinlei121/article/details/78884531

ssim,边缘检测,交叉熵,相关系数,信息熵,边缘保存系数

推荐文章

- 画正弦和余弦曲线,函数或者e的x次方_e的x次方曲线-程序员宅基地

- rsync方法传输系统文件&文件打包及压缩_rsync压缩传输-程序员宅基地

- 记录 | xftp远程连接两台windows_xftp能不能传文件给win10-程序员宅基地

- 解变饱和条件下的修正Picard迭代方法的新收敛准则_picard迭代失效-程序员宅基地

- Sublime编写html中div布局和span行内元素组合_css span拼接商品名-程序员宅基地

- 【vbers】ibv_poll_cq()|RDMA_work request flushed error-程序员宅基地

- 【图像融合】非下采样剪切波算法NSST红外与可见光图像融合(灰度图像)【含Matlab源码 4231期】-程序员宅基地

- 【2023】hadoop基础介绍_hadoop参考文献2023-程序员宅基地

- IOS使用mailcore2发送邮件,qq邮箱发送_airmail unable to authenticate with the current se-程序员宅基地

- 使用fusesource的mqtt-client-1.7-uber.jar,mqtt发布消息出去,接收端看到的是中文乱码,如何解决?-程序员宅基地