”交叉熵“ 的搜索结果

损失函数-交叉熵和二分类交叉熵

机器学习优化中的交叉熵及改进形式 【摘要】目前分类问题广泛的应用到我们的实际生活中[1],因而我们应该研究如何分类,研究它的算法。交叉熵通常在机器学习的分类问题中用作损失函数来判断分类模型的优劣,即把...

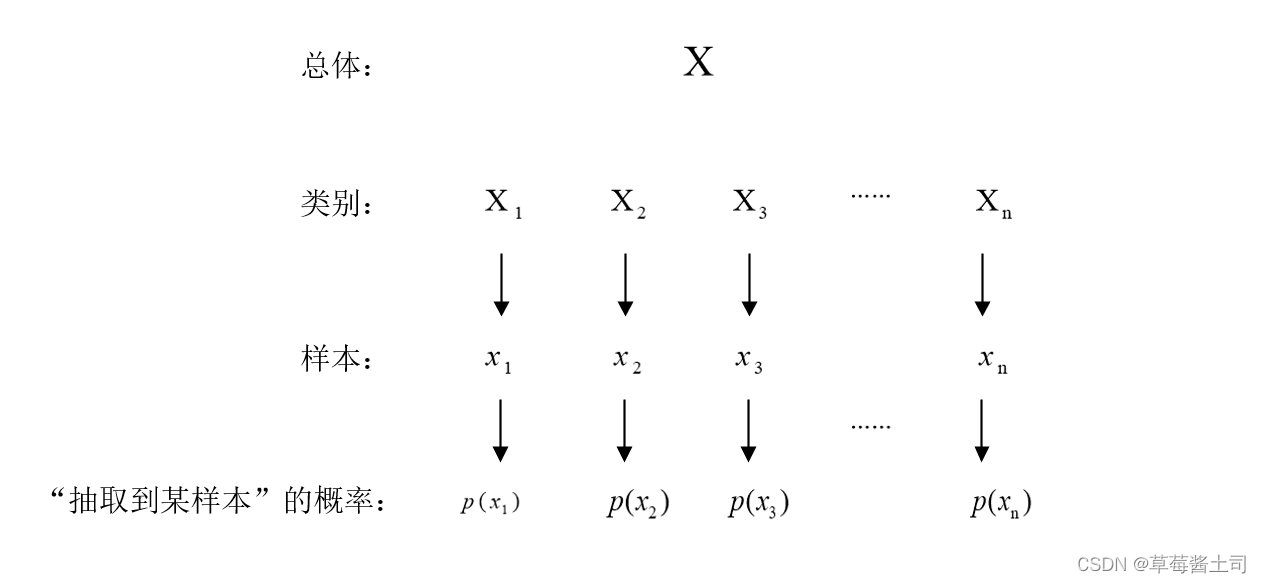

交叉熵是信息论中的一个概念,要想了解交叉熵的本质,需要先从最基本的概念讲起。 1 信息量 首先是信息量。假设我们听到了两件事,分别如下: 事件A:巴西队进入了2018世界杯决赛圈。 事件B:中国队进入了2018世界...

基础不牢,地动山摇,读研到现在有一年多了...交叉熵损失函数(Cross Entropy Loss)在分类任务中出镜率很高,在代码中也很容易实现,调用一条命令就可以了,那交叉熵是什么东西呢?为什么它可以用来作为损失函数?...

交叉熵损失函数_计算机软件及应用_IT/计算机_专业资料。1.从方差代价函数说起...演化算法 [C], 王斌; 李元香 4.一种求解抛物型方程的 Monte Carlo 并行算法 [C], 刘芳芳; 刘播; 刘春光 5.一种求解最大团问题的并行...

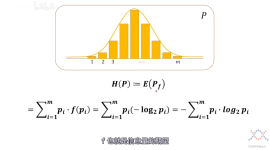

关于交叉熵在loss函数中使用的理解 1.先谈谈信息量: 由于是概率所以p(x0)p(x0)的取值范围是[0,1][0,1],绘制为图形如下:2.熵就是信息量的期望。 3 相对熵(KL散度) 相对熵又称KL散度,如果我们对于同一个...

交叉熵函数直观理解三.交叉熵函数求导3.1Sigmoid + Cross-entropy3.2SoftMax + Cross-entropy四.交叉熵与SoftMax函数 一.交叉熵函数的由来(推导) 我们一共有m组已知样本, (x(i),y(i))(x^{(i)},y^{(i)})(x(i),y(i))...

问的GPT3.5。

基于类内和类间交叉熵的图像分割快速算法,丁力,付明明,提出了基于类内交叉熵和类间交叉熵的灰度图像分割办法,同时针对抗噪性能进行了二维交叉熵概念的推广,并针对二维直方图分割后不

用来计算可靠性失效概率问题,其中针对多设计点问题,采用交叉熵方法

在深度学习领域,交叉熵(Cross Entropy)常被用作分类问题的损失函数。 为知其所以然,本文将详细讲解交叉熵,熵(Entropy),KL散度(Kullback-Leibler Divergence) 的基本概念,并分析常用交叉熵作为分类问题...

交叉熵损失(CrossEntropyLoss)函数是分类任务里最常见的损失函数。当然,CrossEntropy(以下简称“CE”)的作用不仅仅是在简单的分类任务里,比如最近大火的图文多模态模型CLIP就用到CE来进行对比学习,稍微改造...

PyTorch实战:深入理解交叉熵损失函数 在深度学习中,交叉熵损失函数是评估分类模型性能的关键。本文将带你一步步复现交叉熵损失函数,从原理到实现,让你彻底掌握其精髓! #PyTorch #交叉熵损失函数 #深度学习 #...

微分交叉熵法 该存储库由和,包含PyTorch库和源代码,可重现我们在ICML 2020论文中关于。 该存储库取决于 。 我们的代码提供了香草的实现,以实现优化和微分扩展。 核心库源代码在。 我们的实验是在,其中包括产生了...

分类问题常用的损失函数为交叉熵(Cross Entropy Loss)。交叉熵描述了两个概率分布之间的距离,交叉熵越小说明两者之间越接近。熵是信息量的期望值,它是一个随机变量的确定性的度量。熵越大,变量的取值越不确定;...

pytorch 加权交叉熵

针对模糊C-均值聚类(FCM)算法对噪声敏感、容易收敛到局部极小值的问题,提出一种基于交叉熵的模糊聚类算法。通过引入交叉熵重新定义了传统FCM算法的目标函数,利用交叉熵度量样本隶属度之间的差异性,并采用...

【图像分割】基于灰狼算法优化最小交叉熵多阈值图像分割matalb源码

本文主要讲解了分类问题中的二分类问题和多分类问题之间的区别,以及每种问题下的交叉熵损失的定义方法。由于多分类问题的输出为属于每个类别的概率,要求概率和为 1 。因此,我们还介绍了如何利用 Softmax 函数...

推荐文章

- 合成模式(Composite Pattern) _合成模式 csdn 男装-程序员宅基地

- java职业发展路线图_Java开发工程师职业发展及晋升路线图-程序员宅基地

- vue项目input输入框双向绑定数据不实时生效_表单内输入框无法输入双向绑定失效-程序员宅基地

- mysql 前沿表设计_史上最简单MySQL教程详解(基础篇)之表的维护和改造-程序员宅基地

- Python面向对象编程:类与对象-程序员宅基地

- 蚂蚁二面遭JVM调优灵魂拷问,逼得我啃透500页JVM实战笔记,成功上岸京东-程序员宅基地

- 序列号 java_JAVA序列号的serialVersionUID-程序员宅基地

- 推出 TensorFlow 图神经网络 (GNNs)-程序员宅基地

- 产生死锁的必要条件_不是产生线程死锁的必要条件是 一个进程因请求资源而阻塞时,对已获得的资源保特不-程序员宅基地

- android软件安装到平板,新人看过来 安卓平板装机必备软件推荐-程序员宅基地