在机器学习和深度学习中,激活函数、损失函数和优化函数是三个重要的概念,也是在面试中很容易考察你在项目中这些函数选择的时候常问的一些问题。它们在神经网络和其他学习算法中发挥关键作用。优化函数...

”优化函数“ 的搜索结果

Matlab经典优化函数,涵盖了常见的所有优化函数,并详细介绍了其使用方法

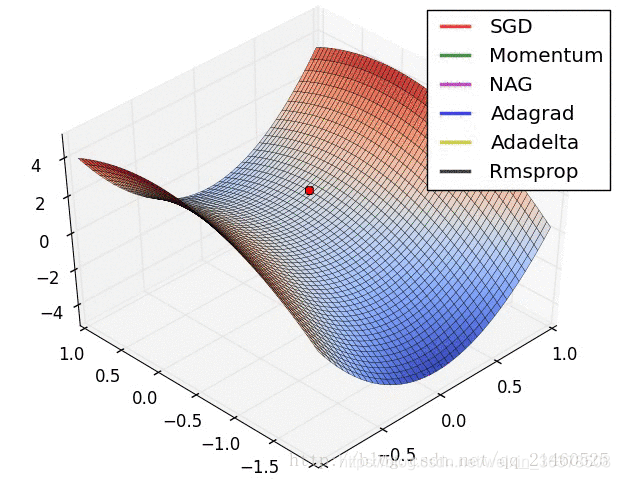

在实践操作中最常用到的是一阶优化函数,典型的一阶优化函数包括GD、SGD、 Momentum、Adagrad、Adam 等等。一阶优化函数在优化过程中求解的是参数的一阶导数,这些一阶导数的值就是模型中参数的微调值。 这里引入了...

在实践操作最常用到的是一阶优化函数。包括GD,SGD,BGD,Adam等。一阶优化函数在优化过程中求解的是参数的一阶导数,这些一阶导数的值就是模型中参数的微调值。 1.梯度下降 梯度下降(Gradient Descent)是参数...

优化算法测试函数MATLAB代码完整版,包含完整的MATLAB代码、数据及算法描述,都在这里了

Matlab优化方法 一、求无约束多变量(多元)极小值...这两个函数都容易陷入局部优化,并且结果的正确与否还要取决 于初值点x0的选取。 1 fminsearch [x,fval,exitflag,output] = fminsearch(…) 结构输出output,...

讲解MATLAB中fmincon函数的调用方法

深度学习中有众多有效的优化函数,比如应用最广泛的SGD,Adam等等,而它们有什么区别,各有什么特征呢?下面就来详细解读一下一、先来看看有哪些优化函数BGD 批量梯度下降所谓的梯度下降方法是无约束条件中最常用的...

损失函数和优化函数的重要性: 深度神经网络中的的损失用来度量我们的模型得到的的预测值和数据真实值之间差距,也是一个用来衡量我们训练出来的模型泛化能力好坏的重要指标。 对模型进行优化的最终目的是尽可能地...

一、算法原理 对于多目标优化问题,matlab提供了fminimax函数。 1、目标函数: ,Z为多目标优化函数 s.t 2、调用格式 x = fminimax(fun,x0) x ...

梯度下降函数也就是优化函数,在神经网络训练过程最重要的函数。重要程度类似于调校对于汽车的重要性,搭建模型和参数设置等操作=“造好了一辆汽车”,优化函数=“调校”。因为汽车最终的操控性和加速性能等指标很大...

zemax优化函数说明书,介绍zemax中的优化函数功能等

激活函数、损失函数、优化函数都分别是什么?有什么作用? 下面,就以激活函数、损失函数、优化函数在神经网络中的作用,浅析一二。 利用神经网络进行分类、检测、分割等任务的关键,就是利用反向传播算法,求解...

梯度下降法(Gradient Descent)优化函数的详解(0)线性回归问题 梯度下降法(Gradient Descent)优化函数的详解(1)梯度下降法(Gradient Descent) 梯度下降法(Gradient Descent)优化函数的详解(2)随机梯度下降...

多目标函数优化算法。

标签: 多目标优化

多目标函数优化有一种方法是,假如现在有n个目标函数fi,首先将每个目标函数乘以一个适当的参数alfai,再将所有的目标函数加起来,得到一个目标函数。这就将多目标函数转化为单目标函数了。 还有一种方法,是真正的多...

NSGA2自定义优化函数MATLAB代码 具体请见http://www.omegaxyz.com/2018/01/22/new_nsga2/

深度学习中波士顿房价预测模型几个优化函数的对比前言一、优化函数的种类?二、波士顿房价预测模型中的效果对比1.SGD2.Adam3.Adagrad4.Momentum三、总结 前言 aistudio官方代码中用的是随机梯度下降SGD的优化函数,...

项目GitHub主页:https://github.com/orobix/retina-unet参考论文:Retina blood vessel segmentation with a convolution neural network (U-net)1. 模型编译model.compile(optimizer='rmsprop',loss='categorical_...

调用格式 [x,fopt,key,c]=fmincon(Fun,x0,A,B,Aeq,Beq,xm,xM,CFun,OPT)[x,f_{opt},key,c]=fmincon(Fun,x_0,A,B,A_{eq},B_{eq},x_m,x_M,CFun,OPT)[x,fopt,key,c]=fmincon(Fun,x0,A,B,Aeq,Beq,xm,xM,CFun,...

R语言中,常用的优化函数知多少,这次将介绍optimize,optimise,optim这三个做优化的函数,也是目前最常用到的优化函数。 做一元的优化:只有要给参数 optimize,optimise,此外,optim也可以做一元优化。前面两个...

fmincon中包含的优化方法共有4种 (1) Trust region reflective (信赖域反射算法) (2) Active set (有效集算法) (3) Interior point (内点算法) (4) SQP (序列二次规划算法) 可通过opti

关于非线性优化fminbnd函数的说明(仅供新手参考) 初学matlab优化,迭代中止后,经常一头雾水。参看帮助后仍似懂非懂。下面关于fminbnd函数的说明(也可作为fmincon函数的参考)对于新手也许会有帮助,不当之处请...

深度学习优化函数详解系列目录 深度学习优化函数详解(0)– 线性回归问题 深度学习优化函数详解(1)– Gradient Descent 梯度下降法 深度学习优化函数详解(2)– SGD 随机梯度下降 深度学习优化函数详解...

推荐文章

- 商业智能软件对比评测: FineBI 和 Tableau -程序员宅基地

- JQuery Ajax Maven [A]_ajaxmaven-程序员宅基地

- 通信原理与MATLAB(八):2PSK的调制解调_psk解调-程序员宅基地

- Halcon 3D定位方法-程序员宅基地

- 用 Hadoop 进行分布式并行编程, 第 3 部分_hdfs dfs -copyfromlocal /home/hadoop/temp/* /tempd-程序员宅基地

- Linux进阶 apache服务器;虚拟主机_虚拟机安装开启httpd服务-程序员宅基地

- 软件测试随笔-程序员宅基地

- VB程序设计教程(第四版) 龚沛曾_龚沛曾vb.pdf-程序员宅基地

- Matlab神经网络语音增强,基于BP神经网络的语音增强研究-程序员宅基地

- java.lang.ClassNotFoundException: org.springframework.core.io.Resource 解决办法-程序员宅基地