”优化器“ 的搜索结果

在PyTorch中,优化器(Optimizer)是用于更新神经网络参数的工具。它根据计算得到的损失函数的梯度来调整模型的参数,以最小化损失函数并改善模型的性能。即优化器是一种特定的机器学习算法,通常用于在训练深度学习...

barra优化器用户手册,这个权威的官方文档,各位搞资产组合优化的伙伴可以参考该文档做组合优化,风险控制。

GFX Tool for PUBG 游戏启动优化器v10.2.5.zip含下载地址可存云盘

摘要:为了提高最小二乘支持向量机(lssvm)的回归预测准确率,对lssvm中的惩罚参数和核惩罚参数利用平衡优化器算法进行优化。

在深度学习中,优化器(optimizer)是一种用于调整神经网络模型参数以最小化损失函数的算法。优化器的目标是根据输入数据和期望的输出标签来调整模型的权重和偏置,使得模型能够更好地拟合训练数据并在未见过的数据...

GUROBI OPTIMIZER REFERENCE MANUAL

在深度学习中,优化器是一个非常重要的组成部分,它通过调整模型参数的方式来最小化损失函数。本教程将介绍三种常用的优化器以及如何选择最合适的优化器。

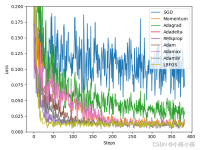

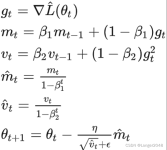

不同的优化器可能会对神经网络的训练效果产生较大影响,因此在实际应用中,我们通常会根据具体问题来选择最合适的优化器。:结合Momentum和RMSprop的概念,在Momentum的基础上计算梯度的一阶矩估计和二阶矩估计,...

在神经网络中,选择合适的损失函数和优化器是非常重要的,因为它们直接影响着机器学习算法的性能和效果。损失函数用于衡量模型预测结果与实际值之间的差异,而优化器则用于调整模型的参数,使得损失函数的值最小化。

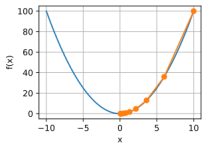

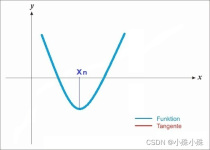

(1)解释一言以蔽之,优化器就是在深度学习反向传播过程中,指引损失函数(目标函数)的各个参数往正确的方向更新合适的大小,使得更新后的各个参数让损失函数(目标函数)值不断逼近全局最小。(2)原理解释优化...

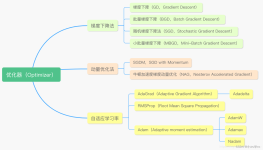

优化器总结 机器学习中,有很多优化方法来试图寻找模型的最优解。比如神经网络中可以采取最基本的梯度下降法。 梯度下降法(Gradient Descent) 梯度下降法是最基本的一类优化器,目前主要分为三种梯度下降法:...

一级研究涉及大部分的研究工作,报告深入研究了全球与中国功率优化器市场的竞争格局,其中分析师与关键意见领袖、行业领袖和意见制造者进行了访谈,确定了在全球与中国功率优化器市场运作的主要参与者,其中每一个...

1.版本:matlab2014/2019a/2021a 2.附赠案例数据可直接运行matlab程序。 3.代码特点:参数化编程、参数可方便更改、代码编程思路清晰、注释明细。 4.适用对象:计算机,电子信息工程、数学等专业的大学生课程...

目前有两种主流优化器:随机梯度下降系(Stochastic Gradient Descent, SGD)和Adam系。应该认识到的是,优化器并不是某类数学上的优化算法,而是梯度下降(一阶迭代法)的工程实现方案和包装。

优化器是深度学习中用于优化神经网络模型的一类算法,其主要作用是根据模型的损失函数来调整模型的参数,使得模型能够更好地拟合训练数据,提高模型的性能和泛化能力。优化器在训练过程中通过不断更新模型的参数,使...

文章详细介绍了优化器在深度学习中的作用,按照出现时间的顺序依次介绍各种优化器的实现原理附带个人理解的通俗数学公式,而且有torch中封装好的函数类用法和参数介绍等等,也包括优化器各自的优缺点,以及常用超...

1.版本:matlab2014/2019a/2021a 2.附赠案例数据可直接运行matlab程序。 3.代码特点:参数化编程、参数可方便更改、代码编程思路清晰、注释明细。 4.适用对象:计算机,电子信息工程、数学等专业的大学生课程...

探索阿里巴巴的MiniOptimizer:一款高效的深度学习优化器 项目地址:https://gitcode.com/alibaba/MiniOptimizer 简介 在深度学习领域,优化器是模型训练过程中的关键组件,它决定了模型参数更新的方式和效率。阿里...

这是一个系列,以Pytorch为例,介绍所有主流的优化器,如果都搞明白了,对优化器算法的掌握也就差不多了。作为系列的第一篇文章,本文介绍Pytorch中的SGD、ASGD、Rprop、Adagrad,其中主要介绍SGD和Adagrad。因为这...

本文提出了一种基于藤壶交配优化器 (BFO)、泥模算法 (MFA) 和海洋捕食者算法 (OFA) 的混合算法,用于解决带障碍的二维布局优化问题。该算法结合了 BFO 的全局搜索能力、MFA 的局部搜索能力和 OFA 的平衡探索和利用...

本文提出了一种基于藤壶交配优化器 (BFO)、泥模算法 (MFA) 和海洋捕食者算法 (OFA) 的混合算法,用于解决带障碍的二维布局优化问题。该算法结合了 BFO 的全局搜索能力、MFA 的局部搜索能力和 OFA 的平衡探索和利用...

AdamW

推荐文章

- Windows系统鼠标右键菜单添加打开cmd终端_we右键进入cmd-程序员宅基地

- python汇编语言还是机器语言_深入理解计算机系统(3.1)------汇编语言和机器语言...-程序员宅基地

- android毕设各种app项目,安卓毕设,android毕设_app毕业设计-程序员宅基地

- Keil侧边工具栏(项目窗口)打开方式_keil侧边栏-程序员宅基地

- 算法学习,转载记录(持续记录)-程序员宅基地

- 局域网探测器_局域网检测-程序员宅基地

- 【C语言基础系列,阿里java面试流程_c语言java面试-程序员宅基地

- Linux技术简历项目经验示例(二)_linux简历工作经验怎么写-程序员宅基地

- 安卓手机软键盘弹出后不响应onKeyDown、onBackPressed方法解决方案-程序员宅基地

- 使用二维数组实现存储学生成绩_c#创建控制台应用程序studentscore,生成学生成绩单——二维数组的使用。-程序员宅基地